Według specjalistów z Depix Technologies renderowanie „jednym kliknięciem” stało się rzeczywistością

Opracowanie: Maciej Stanisławski

Koniec z powolnym konfigurowaniem, definiowaniem materiałów, czy dobieraniem położenia wirtualnych kamer. Koniec z ustawianiem tła, sceny i odpowiedniego oświetlenia. Wystarczy jedno kliknięcie, a kilka sekund później otrzymujemy gotowy render. W dodatku… nie potrzebujemy wysyłać modelu 3D… wystarczy zrzut ekranu!

– To tak proste, że aż przerażające – powiedział portalowi Engineering.com Philip Lunn, dyrektor generalny Depix Technologies, w rozmowie z red. Michaelem Albą.

Renderowanie generatywne

Niektóre zastosowania generatywnej sztucznej inteligencji na potrzeby szeroko rozumianego projektowania inżynieryjnego są oczywiście na wczesnym etapie, o czym wspominałem już na łamach CADblog.pl. Co prawda SI (ang. GenAI) może już tworzyć edytowalne, parametryczne modele 3D – jeśli nie są zbyt skomplikowane, może przeprowadzać analizy i symulacje – w określonym zakresie i warunkach. Jej mechanizmy sprawdzają się „w tle” systemów CAD/CAE, wspomagając projektantów poprzez podpowiadanie odpowiednich narzędzi, procesów, ew. wariantów danego modelu. Ale w przypadku zastosowań graficznych GenAI „obrosła już w piórka”.

Chociaż obrazy wygenerowane przez AI różnią się jakością, najlepsze mogą być niezwykle przekonujące i doskonale udawać rzeczywistość. A nawet jeśli można stwierdzić, że obraz został wygenerowany przez sztuczną inteligencję, często nie ma to znaczenia, jeśli spełnia swoje zadanie wystarczająco dobrze.

Renderowanie to w zasadzie nic innego jak tworzenie obrazu – oczywiście na podstawie określonych danych wejściowych (modelu 3D) – dlatego kwestią czasu było zaprzęgnięcie sztucznej inteligencji do tej pracy. Okazuje się, że efekty są rewelacyjne. Ba, cytowany już Philip Lunn, który działa w branży oprogramowania do renderowania od 1997 roku, twierdzi, iż jest to wręcz… rewolucja w tym obszarze.

CADviz. Model 3D nie jest potrzebny?

Okazuje się, że GenAI (ang. Generative Artificial Intelligence) nie potrzebuje nawet modelu CAD, aby stworzyć fantastyczny rendering; wystarczy jedynie zrzut ekranu z takim modelem (może być nawet widoczny interfejs programu). Ale podobnie będzie… np. ze szkicem ołówkiem, zeskanowanym lub tylko sfotografowanym smartfonem. Depix Technologies opracowała generator obrazów AI specjalizujący się w wykonywaniu profesjonalnych renderingów, na podstawie zdjęć modeli 3D lub wręcz odręcznych szkiców.

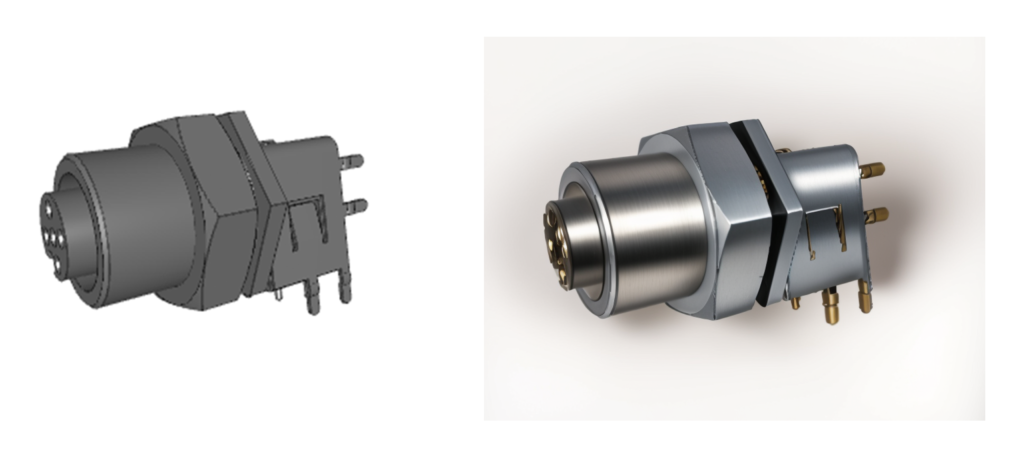

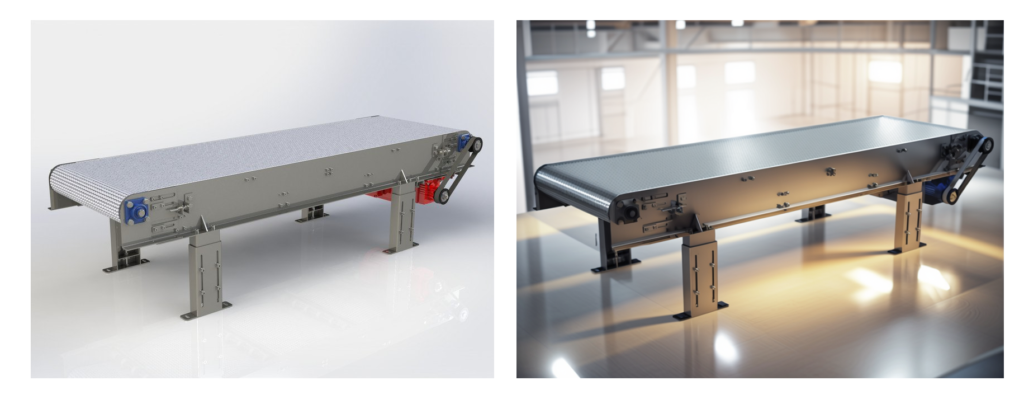

Poniżej zamieszczam kilka zestawień obrazów. Te po lewej to „oryginały”, pochodzące z różnych systemów CAD. Te po prawej – to renderingi z CADviz, jednego z produktów Depix, który wykorzystuje zrzut ekranu CAD i na jego podstawie generuje i wyświetla gotowy render.

Użytkownik nie musi podawać żadnych szczegółów dotyczących renderowania — żadnych materiałów, żadnych informacji o scenie, kompletnie nic. Wygenerowanie renderu na podstawie zrzutu ekranu CADviz zajmuje około 5-15 sekund, w zależności od stopnia złożoności „wejściowego” obrazu.

CADviz jest bezpłatny, ale w wariancie „free” dostęp do jego funkcji jest mocno ograniczony. Wersja „Pro”, odpłatna, ma być udostępniona już niedługo i oferować m.in. renderowanie w wysokiej rozdzielczości. Link do programu (działającego via cloud) tutaj.

SceneShift i StyleDrive

Inny produkt Depix, SceneShift, to krok dalej. Ten program łączy podpowiedzi tekstowe z kluczowym ograniczeniem renderowania produktu: zachowaniem oryginalnego kształtu modelu. Wystarczy dostarczyć zdjęcie gotowego produktu, modelu 3D albo renderu (chociażby z CADviz) i opatrzyć odpowiednim komentarzem – np. z żądaniem nowego tła, a po kilku(nastu) sekudach otrzymamy zupełnie nowy rendering: nową scenę, nowe oświetlenie, ale ten sam model. Przykład działania SceneShift poniżej.

StyleDrive

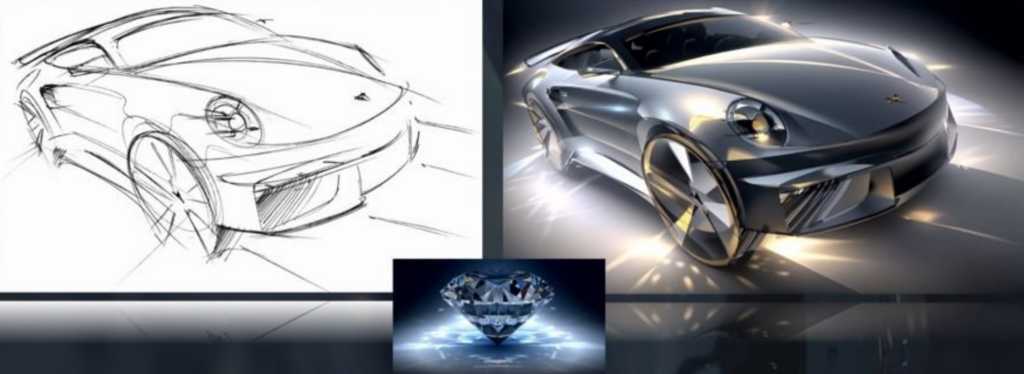

Kolejne narzędzie Depix – StyleDrive, pozwala na przesłanie dwóch obrazów: jeden to nazwijmy to „obraz bazowy”, przedstawiający interesujący nas obiekt, model etc. Drugi to „referencja” stylu, w jakim obraz bazowy ma być finalnie przedstawiony.

Nie ma żadnych ograniczeń co do tego, czym może być każdy obraz. Projektant może naszkicować samochód i zastosować styl diamentu, jak w poniższym przykładzie. Firma twierdzi, że ma już wielu komercyjnych klientów z sektora automotive. I jestem skłonny w to uwierzyć, patrząc na efekty działania oprogramowania StyleDrive…

Co znajdziemy „w środku”?

Model sztucznej inteligencji wykorzystywanej przez Depix Technologies opiera się na Stable Diffusion – modelu open source – „wyszkolonym” (uczenie maszynowe) na… ok. 5 milionach obrazów, dzięki czemu radzi sobie z wieloma tematami (nie tylko inżynieryjnymi). Philip Lunn wyjaśnia, że użytkownicy będą mogli „spersonalizować” renderującą sztuczną inteligencję za pomocą niestandardowych danych szkoleniowych (do 1000 obrazów). Mogą one zawierać szkice, modele CAD, rendery lub inne obrazy, które pozwolą „dostroić” wyjściowe renderingi w pożądanym przez użytkownika kierunku.

Narzędzia AI firmy Depix są dostępne jako indywidualne interfejsy API oraz razem w interfejsie zwanym Depix Design Lab. W tej chwili każdy może przetestować tę technologię na serwerze Discord firmy Depix Technologies. Lunn ma nadzieję, że pewnego dnia narzędzia Depix zostaną zintegrowane z profesjonalnym oprogramowaniem, takim jak CAD i PLM. Mówi, że firma prowadzi rozmowy z kilkoma programistami z branży… i kilkoma dostawcami takich rozwiązań. Pozostaje czekać i śledzić informacje prasowe…

(ms)

Źródło: Michael Alba: „The AI rendering revolution. This makes designers cry”. Engineering.com

Bądź pierwszy, który skomentuje ten wpis